# 一、DeepSeek简介

DeepSeek官网:https://www.deepseek.com (opens new window)

DeepSeek 杭州深度求索人工智能基础技术研究有限公司

# 1 公司背景与资源

- 成立时间与背景:DeepSeek,全称杭州深度求索人工智能基础技术研究有限公司(简称“深度求索”或“DeepSeek”),成立于2023年7月17日,是幻方量化公司旗下的开源大模型平台。

- 自研资源:基于自研训练框架、自建智算集群和万卡算力等资源,DeepSeek团队在短时间内取得了显著的成果。

# 2 模型发布与开源

- 模型发布:DeepSeek已经发布并开源了多个百亿级参数大模型,如DeepSeek-LLM通用大语言模型、DeepSeek-Coder代码大模型等。2024年1月,DeepSeek率先开源了国内首个MoE大模型(DeepSeek-MoE)。

- 开源策略:DeepSeek全系列模型已经完全开源,并且免费商用,为广大开发者和企业提供了经济实惠的选择。

# 3 模型性能与应用

- 出色表现:DeepSeek的各大模型在公开评测榜单及真实样本外的泛化效果均有超越同级别模型的出色表现。

- 多任务执行:DeepSeek旨在通过自然语言处理和机器学习算法来理解和回应用户的查询,可以执行多种任务,包括但不限于通识对话、代码助手等。

- 通识对话:用户可以在web端在线使用DeepSeek的通识对话功能,通过手机号注册登录后即可免费体验。

- 代码助手:用户可以提问任何代码相关问题,DeepSeek能够生成准确的代码回答。

# 4 代表性模型

- DeepSeek V3

- 参数量与预训练:DeepSeek V3是一个参数量为671B的MoE模型,激活37B,在14.8T高质量token上进行了预训练。

- 测评表现:在多项测评上,DeepSeek V3达到了开源SOTA,超越Llama 3.1 405B,能和GPT-4o、Claude 3.5 Sonnet等TOP模型相媲美。

- 性价比:DeepSeek V3的训练成本相对较低,仅为Claude 3.5 Sonnet的9%,同时提供了优惠的API价格。

- 技术特点:

- 采用了创新的负载均衡策略和训练目标,提高了模型性能。

- 首次验证了FP8训练在极大规模模型上的可行性和有效性。

- 引入了冗余专家的部署策略,实现了MoE不同专家之间的负载均衡。

- 应用表现:DeepSeek V3在推理速度上相较历史模型有了大幅提升。在目前大模型主流榜单中,DeepSeek-V3在开源模型中位列榜首,与世界上最先进的闭源模型不分伯仲。

- R1模型

- 技术突破:据DeepSeek公司介绍,R1模型在技术上实现了重要突破,即用纯深度学习的方法让AI自发涌现出推理能力,在数学、代码、自然语言推理等任务上,性能比肩美国开放人工智能研究中心(OpenAI)的GPT-4模型正式版。

- 成本优势:R1模型延续了DeepSeek高性价比的优势,其训练成本仅为560万美元,远远低于美国开放人工智能研究中心、谷歌、“元”公司等美国科技巨头在人工智能技术上投入的数亿美元乃至数十亿美元。

# 5 产品与服务

- DeepSeek APP:由DeepSeek V3模型驱动,具备强大的逻辑推理能力、联网搜索功能以及拍照识文字功能等。与ChatGPT相比,DeepSeek APP在功能上毫不逊色,甚至在某些方面更具优势,且完全免费使用。

- API服务:对于开发者来说,创建和使用DeepSeek的API非常便捷。API文档详细,示例代码丰富,可以帮助开发者快速集成到自己的应用中。且API服务的价格合理,使得个人开发者和小型团队也能负担得起。

# 6 市场反响与影响

- 市场关注:DeepSeek的模型和应用程序受到了市场的广泛关注。其开发的模型在多项测试中的表现都优于OpenAI,且设计成本较低。DeepSeek应用程序已取代竞争对手OpenAI的ChatGPT,成为美国苹果应用商店下载量最大的免费应用程序。

- 股市影响:DeepSeek的突破动摇了美国科技行业的地位。因受到DeepSeek人工智能模型冲击,美国芯片巨头英伟达(NVIDIA)等科技公司的股价大幅下跌。

# 7 未来展望

虽然当前版本的DeepSeek在功能和性能上已经取得了显著的成果,但其在多模态支持方面仍存在一些局限。不过,DeepSeek团队表示未来会在基座模型上增加多模态功能,以提供更全面的AI服务。

# 二、Ollama介绍

Ollama 是一个开源的、易于使用的本地大语言模型(LLM)运行平台,简单,高效,可以扩展,可以运行各种主流模型。

# 三、DeepSeek使用

# 1 安装Ollama

打开Ollama官网:https://ollama.com (opens new window)

点击Download进入下载页面,根据自己的电脑系统选择对应版本。

目前支持Windows,macOS,Linux。苹果平台的Inter内核和M1系列都支持!!!

我这里用的是Windows平台 (opens new window),直接获取exe应用程序,双击安装。

点击Install,然后全部默认,一路到底(默认是安装在C盘)。

安装完成之后,会自动启动,右下角托盘上会显示应用图标。

这个时候,打开命令行,输入命令:

ollama -v

ollama version is 0.5.7

# 移植到非C盘

1、迁移Ollama安装目录

将Ollama的安装目录从默认的C盘移动到D盘。这包括移动Ollama可执行文件所在的目录以及模型文件所在的目录。

具体步骤如下:

- 将

C:\Users\XX\AppData\Local\Programs\Ollama这个文件夹 (opens new window)移动到D盘,例如改为D:\Ollama。 - 同时,将模型文件所在的目录

C:\Users\XX.ollama也移动到D盘,例如改为D:\Ollama.ollama。

2、修改环境变量

修改系统的环境变量,以便Ollama能够正确找到新的安装位置。

具体步骤如下:

- 修改用户变量的PATH变量,将原来的

C:\Users\XX\AppData\Local\Programs\Ollama路径更新为新的位置,即D:\Ollama。 - 在系统变量中新建一个名为

OLLAMA_MODELS的变量,设置其值为模型文件的新位置,例如D:\Ollama\models。

# 2 加载DeepSeek模型

打开Ollama官网 (opens new window),点击Models。一眼就能看到deepseek-r1,排在最上面。

点击deepseek-r1进入详情页面,可以看到这个这个模型的描述信息为“DeepSeek 的第一代推理模型,性能与 OpenAI-o1 相当。”

复制并运行命令:

ollama run deepseek-r1

ollama就开始载入模型了,第一次运行会联网下载。第二次就会直接从本地载入。

默认的模型是7B Q4的量化版。大小为4.7G。

模型下载完成之后,就可以开始对话了。直接输入你的问题,按回车就好了。

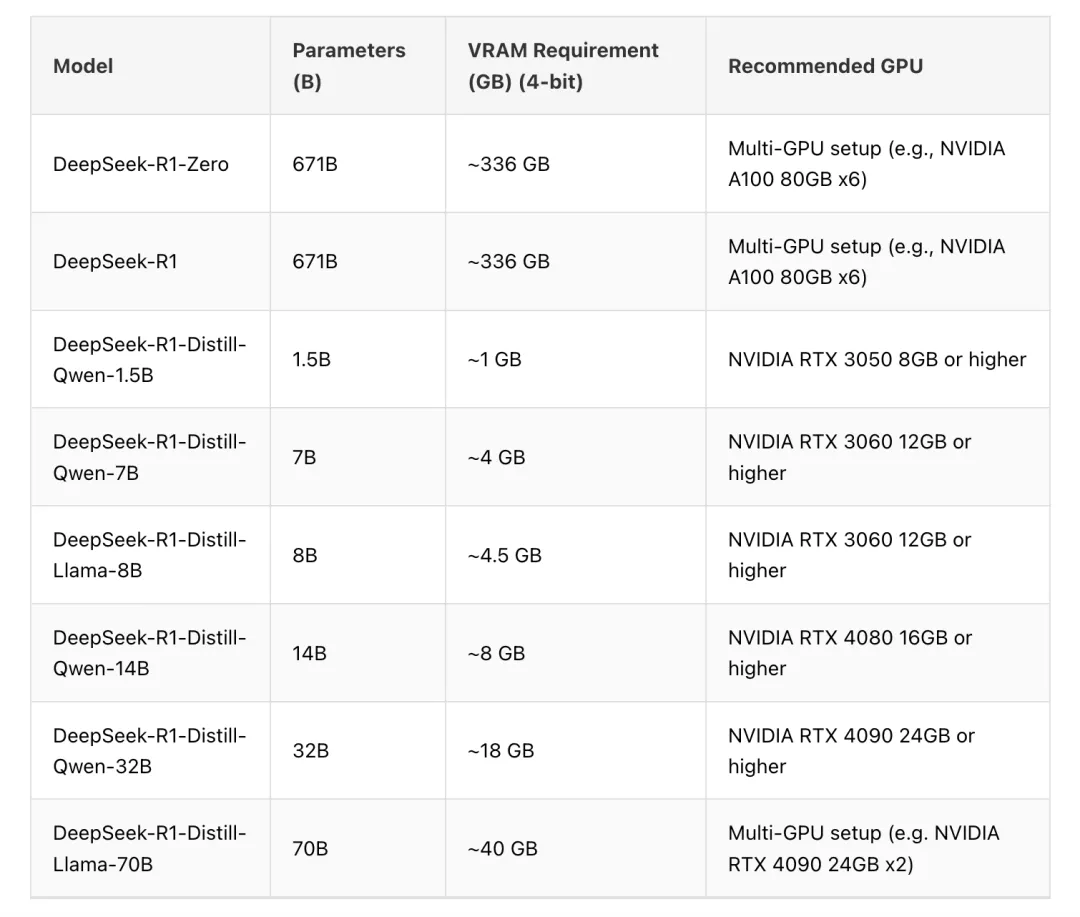

# 其他模型

# 3 客户端

Windows可以使用CMD、Powershell运行ollama命令。

MacOS可以使用iTerm、Terminal。

Linux就随意了。

也可以本地部署对话客户端,利用第三方客户端实现便捷展示与使用,如

Open WebUI、Chatbox AI等。

# Open WebUI

Open WebUI 是一款功能强大、可扩展性高且用户体验极佳的自托管 AI 平台,其亮点在于能够完全离线运行。它广泛支持各种 LLM 运行器,无论是 Ollama,还是 OpenAI 兼容的 API,它都能适配,并且内置的 RAG 推理引擎,更是大幅提升了其 AI 部署能力,使其成为一款不可多得的 AI 部署解决方案。

# Chatbox AI

Chatbox AI 是一款桌面客户端应用和智能助手,旨在为用户提供更便捷、高效的方式与 AI 交互。支持众多先进的 AI 模型和 API,可在 Windows、MacOS、Android、iOS、Linux 和网页版上使用。

1、下载

2、安装

傻瓜式安装......

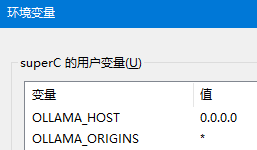

3、配置环境变量

OLLAMA_HOST和OLLAMA_ORIGINS是Ollama的配置环境变量,用于配置Ollama与其API服务器之间的通信。

OLLAMA_HOST:用于指定 Ollama 服务监听的主机地址和端口。默认情况下,Ollama 会绑定到 127.0.0.1:11434(仅本地访问)。通过修改此变量,可以实现以下场景:

- 允许其他设备通过局域网访问 Ollama。

- 在 Docker 容器或云服务器中运行时,开放对外访问。

我们可以配置为0.0.0.0, 表示开放到所有IP,允许所有网络接口访问。

OLLAMA_HOST=0.0.0.0:114341OLLAMA_ORIGINS:用于控制Ollama API的跨域请求来源(CORS)。默认情况下,Ollama仅允许同源请求(即与 API 同域名/端口)。若需要从其他域名或端口调用 API(例如通过自定义 Web 前端),需通过此变量指定允许的来源。

示例:允许特定域名或端口

OLLAMA_ORIGINS=http://localhost:3000,https://example.com1我们可以配置为*, 表示允许所有来源。

OLLAMA_ORIGINS=*1

Windows如何配置用户环境变量。

4、启动DeepSeek

打开cmd运行以下命令。

# 启动ollama服务

ollama serve

2

5、配置ChatBox

打开ChatBox,选择模型提供方OLLAMA API,选择对应的模型deepseek r1。

之后,我们就可以使用Chatbox和DeepSeek对话了。

# 四、与ChatGPT-O1对比

| DeepSeek-R1 | ChatGPT-O1 | |

|---|---|---|

| 开发者 | DeepSeek 深度求索 | OpenAI |

| 官网 | https://www.deepseek.com (opens new window) | https://openai.com/chatgpt (opens new window) |

| 基础参数 | 目前尚未公布详细参数,是基于大语言模型(LLM)设计的。 | 作为 OpenAI 的最新版本,其参数规模可能更大(例如,可能是 7B 或 13B 参数级别的模型)。 |

| 应用场景 | 其功能类似于 ChatGPT,但可能在某些特定领域有更强的适应性。 | 适用于通用对话、文本生成、翻译、摘要、问答等任务,并且 OpenAI 提供了付费支持。 |

| 支持任务 | 一个专门设计的模型,可能在特定任务(如数学计算、编程、科学推理)上有更强的表现。 | 专注于通用对话和语言生成任务,适合非技术用户。 |

| 扩展能力 | 支持知识图谱或外部数据源,可能在特定领域有更深入的理解和应用。 | 默认情况下不连接互联网(除非付费解锁),但可以通过调用额外的 API 或者自定义模型扩展功能。 |

| 价格 | 尚未公布价格,作为开源或社区版本可能免费。 | OpenAI 提供付费访问,具体费用取决于使用时长和频率。 |